Das erwartet dich hier:

Du hast eine tolle Website – aber wie sicher bist du dir, dass sie von Suchmaschinen wie Google & Co. gefunden wird? Die Indexierung und das Crawling sind entscheidende Faktoren die bestimmen, ob deine Website in den Suchergebnissen erscheint oder nicht.

Grundsätzlich gilt: Wenn der Crawler der Suchmaschine die Website nicht findet oder deine Website nicht richtig indexiert wurde, wird sie in den Suchergebnissen unsichtbar bleiben. Es ist wichtig zu verstehen, wie die Indexierung und das Crawling funktionieren. In diesem Blogbeitrag erfährst du, warum eine richtige Indexierung und ein effektives Crawling für die Sichtbarkeit deiner Website in den SERPs von großer Bedeutung sind. Also, lass uns in das Thema eintauchen und herausfinden, wie du sicherstellen kannst, dass deine Inhalte nicht länger unsichtbar bleiben.

Was ist Crawling?

Ein Crawler, Spider oder auch Robot genannt, ist ein Programm, dass das Internet ständig nach neuen oder aktualisierten Inhalten durchforsten und diese in den Index der Suchmaschine hinzufügt. Dabei folgen sie den internen und externen Links auf einer Seite, in einer Art Spinnennetz und sammeln neue Informationen zu URLs, um möglichst viele Seiten zu indexieren.

Wenn deine Webseite nicht crawlbar ist, wird Google sie auch nicht finden können. Somit bleibt deine Website nicht indexiert. Um sicherzustellen, dass deine Website gecrawlt wird, prüfe, ob alle Links erreichbar sind und eine robots.txt-Datei vorhanden ist.

Was bedeutet Indexierung?

Wenn es um die Indexierung geht, steht meist Google im Fokus. Doch was bedeutet eigentlich Indexierung? Indexierung bedeutet, dass Inhalte einer Website von Suchmaschinen erfasst und in deren Datenbanken gespeichert werden. Vereinfacht gesagt ist es der Prozess, bei dem eine Suchmaschine wie Google Webseiten scannt und sie in ihrem Index speichert. Der Index ist quasi das Herzstück einer Suchmaschine. Er enthält alle Informationen über jede gescannte Webseite.

Je besser eine Webseite indexiert wird, desto höher ist ihre Sichtbarkeit in den Suchergebnissen. Allerdings gibt es auch Faktoren wie Qualität des Inhalts, Backlinks und technische Aspekte wie Ladezeit oder mobile Optimierung, die ebenfalls Einfluss auf das Ranking haben können.

Gut zu wissen: Ohne Crawling keine Indexierung und ohne Indexierung kein Ranking!

Ist deine Seite überhaupt sichtbar?

Wenn du eine Website besitzt, ist es von entscheidender Bedeutung, dass sie auch von Suchmaschinen gefunden wird. Doch wie kannst du sicherstellen, dass deine Seite überhaupt sichtbar ist? Es gibt zwei Möglichkeiten dies zu prüfen. Mit der Site-Abfrage und der Google Search Console kannst du schnell und einfach herausfinden, ob Google auf deine Seite zugreifen kann und welche Seiten indexiert wurden.

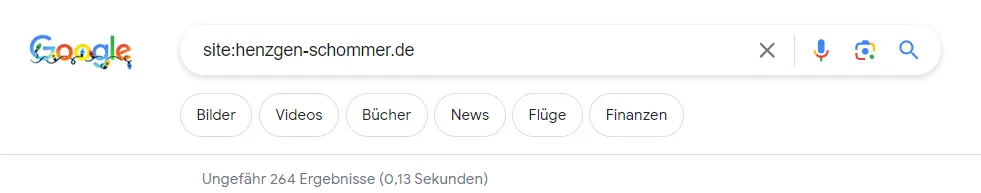

Site-Abfrage

Die Site-Abfrage ist ein wichtiger Schritt um herauszufinden, ob deine Website überhaupt indexiert ist. Dazu gibst du einfach “site:domain.com“ in dem Google Suchfeld ein und du erhältst sofort eine Auflistung aller indexierten Seiten, welche zu einer Domain im Index zu finden sind, inklusive deren Anzahl.

Abbildung: Site-Abfrage bei Google

Du kannst die Site-Abfrage natürlich eingrenzen und nach den indexierten URLs für bestimmte Verzeichnisse oder einer Unterseite suchen:

site:https://www.domain.com/unterseite

Wenn die Seite in den Suchergebnissen erscheint bedeutet das, dass sie gecrawlt und indexiert wurde. Sollte dies nicht der Fall sein, dann solltest du prüfen, ob es Probleme mit der Indexierung gibt oder die Webseite möglicherweise gegen Google-Richtlinien verstößt.

In der Suchmaschinenoptimierung nutzt man die Site-Abfrage um schnell herauszufinden, ob es Handlungsbedarf gibt. Werden Indexierungsprobleme festgestellt, können diese anschließend behoben werden.

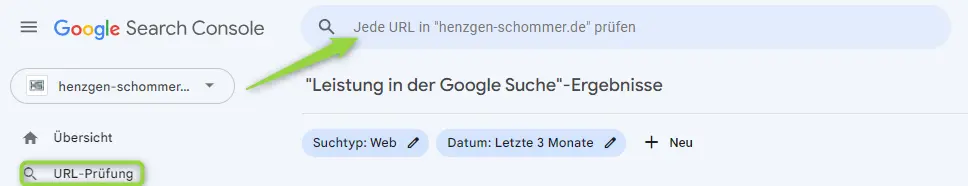

Search Console URL Prüfung

Die zweite Möglichkeit dies zu überprüfen, ist die Nutzung der URL-Prüfung in der Search Console von Google. Hier kannst du gezielt einzelne URLs deiner Website prüfen lassen und erhältst Informationen darüber, ob diese von Google indexiert wurden oder nicht. Auch Fehlermeldungen werden hier angezeigt und können behoben werden. So kannst du sicherstellen, dass alle relevanten Seiten deiner Website sichtbar sind und von Suchmaschinen gefunden werden können. Die Search Console URL-Prüfung ist also ein unverzichtbares Tool für jeden Websitebetreiber, um die Sichtbarkeit der eigenen Seite zu optimieren.

Abbildung: URL-Prüfung mit der Google Search Console

Noch kein Google-Konto? Dann erstelle jetzt schnell eins!

Google bietet viele praktische Google-Dienste und kostenlose SEO Tools an, die dir bei der Optimierung deiner Website helfen können: Google Search Console und Google Analytics.

Crawling- und Indexierungsfehler verstehen

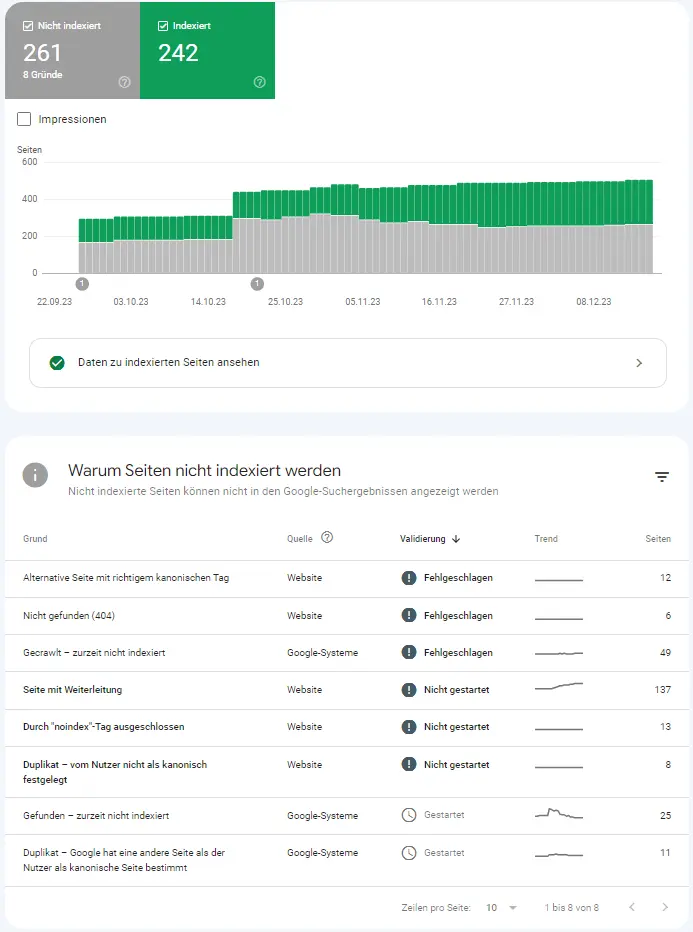

Eine effiziente Methode, um Crawling- und Indexierungsfehler zu identifizieren, ist die Nutzung der Google Search Console. Wo du diese finden kannst? In der linken Seitenleiste unter dem Menüpunkt Indexierung → Seiten erhältst du einen Überblick darüber, wie viele Seiten deiner Website bereits indexiert und nicht indexiert sind. Weiter unten in dem GSC-Bericht bekommst du eine Auskunft, welche URLs von Google erfolgreich indexiert wurden, bei welchen URLs es Probleme mit dem Crawling oder der Indexierung gegeben hat und welche Gründe dahinterstecken. Diese findest du im Bereich “Warum Seiten nicht indexiert werden”.

Die Google Search Console liefert noch mehr detaillierte Informationen zu URLs, Keywords und Leistungsdaten deiner Website. Wenn du noch mehr Tipps möchtest: Alles Wichtige über die GSC erfährst du in unserem Blogbeitrag zur Google Search Console.

Abbildung: Google Search Console – Bericht zur Crawling und Indexierung

Wir zeigen dir, welche Crawling- und Indexierungsprobleme es in der Search Console gibt, was diese bedeuten und wie du sie am besten lösen kannst.

Alternative Seite mit richtigem kanonischen Tag

Was bedeutet „alternative Seite mit richtigem kanonischen Tag“? Hier werden Seiten aufgelistet, die über mehrere URLs erreichbar sind. Bei den aufgelisteten URLs hast du eine alternative Seite mittels eines kanonischen Tags angegeben und dieser wurde von Google angenommen. Der kanonische Tag wurde korrekt gesetzt und zeigt auf die richtige URL, sodass du nichts unternehmen musst.

Lösung: Kein Handlungsbedarf.

Duplikat – vom Nutzer nicht als kanonisch festgelegt

Es wurde ein Duplikat einer anderen Seite erkannt, die vom Nutzer nicht als kanonisch definiert wurde. Dies bedeutet, dass es mehrere Versionen derselben Seite gibt aber keine davon wurde als die Hauptversion (kanonische Version) markiert. Google hat eine andere Seite als kanonische Version festgelegt und wird diese Seite nicht im Google Index aufnehmen.

Lösung: Die richtige kanonische Seite angeben.

Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt

Die aufgeführten Seiten in diesem Abschnitt beinhalten einen Canonical Tag, der vom Betreiber der Website festgelegt wurde. Jedoch entscheidet Google, dass eine andere URL sich als kanonische Seite eignet und wählt stattdessen diese aus. Der von dir eingerichtete Canonical Tag wird dabei ignoriert und die URL wird nicht in den Index aufgenommen.

In diesem Fall solltest du sicherstellen, dass der kanonische Tag auf der von dir bevorzugten Seite platziert ist und dass alle internen Links auf diese Seite verweisen. Wenn dies nicht hilft, kannst du auch versuchen die Inhalte der beiden Seiten zu differenzieren oder sie ganz zusammenzuführen.

Lösung: Die richtige URL als kanonisch bestimmen sowie Inhalte anpassen, interne Verlinkung optimieren oder die von Google bestimmte URL aus dem Index entfernen.

Durch „noindex“-Tag ausgeschlossen

Die aufgelisteten URLs in der Google Search Console unter dem „noindex“-Tag ausgeschlossen Vermerk sind Seiten, die vom Googlebot gecrawlt wurden, aber nicht im Index aufgenommen sind. Durch den gesetzten „noindex“ Metatag darf Google die Seite nicht indexieren.

Lösung: Wenn wichtige Seiten indexiert werden sollen, den „noindex“ Tag entfernen. Ansonsten besteht kein Handlungsbedarf.

Gecrawlt – zurzeit nicht indexiert

Die URL wurde zwar gecrawlt, aber noch nicht indexiert. Das kann verschiedene Gründe haben:

Am besten überprüfst du in der Google Search Console jede einzelne URL mit Hilfe der URL-Prüfung. Wichtig ist, dass keine deiner bedeutenden Seiten unter „gecrawlt – zurzeit nicht indexiert“ zu finden ist. Wenn es dir auffällt, dass wichtige Seiten trotz erfolgreichen Crawlings nicht indexiert wurden, solltest du schnell nach möglichen Ursachen suchen.

Lösung: Die Seite individuell mit der URL-Prüfung analysieren. Die Lösung ist vom Ergebnis abhängig, ggf.: Ausschluss irrelevanter URLs über die robots.txt Datei. Erneute Beantragung der Indexierung. Optimierung interner Verlinkung. Duplicate Content – prüfen. Sitemap erstellen. Content erweitern.

Gefunden – zurzeit nicht indexiert

Ein zweiter sehr ähnlicher Bericht ist – „gefunden – zurzeit nicht indexiert“. Die URL wurde von Google gefunden jedoch nicht gecrawlt und nicht indexiert. Es gibt verschiedene Gründe, warum die Seite nicht gecrawlt wurde. Möglicherweise hat die Seite keinen ausreichenden, irrelevanten Inhalt oder aus technischen Gründen wurde die Seite nicht gefunden.

Lösung: Gleiche Vorgehensweise wie bei gecrawlt – zurzeit nicht indexiert“

Nicht gefunden (404)

Wenn der Crawler die angeforderte URL nicht finden kann, wird der HTTP-Statuscode 404 ausgegeben. Dieser Fehler tritt auf, wenn z. B. eine Seite gelöscht oder verschoben wurde.

Wenn solche Crawling-Fehler auf deiner Website bestehen, solltest du diese so schnell wie möglich beheben. Denn je mehr 404-Fehler deine Website hat, desto schlechter ist das Nutzererlebnis und desto inneffizierter wird dein Crawling-Budget für die Website verwendet.

Lösung: 301-Weiterleitung einrichten.

Wegen Zugriffsverbot (403) blockiert

Die Inhalte sind für Google-Bots nicht zugänglich. Dies kann verschiedene Gründe haben:

Lösung: Wenn das Zugriffsverbot nicht gewünscht ist, dem Crawler uneingeschränkten Zugriff erlauben und nicht angemeldete Benutzer zulassen. Wenn das Zugriffsverbot gewünscht ist empfehlen wir die Seite durch robots.txt oder ggf. „noindex“ Tag zu blockieren.

Wegen nicht autorisierter Anforderung (401) blockiert

Die Blockierung von URLs für den Googlebot erfolgt durch eine Autorisierungsanforderung (401-Fehler).

Lösung: Wenn die URL nicht indexiert werden soll, die URL aus der Sitemap entfernen und ggf. auf „noindex“ setzen. Wenn die Seite indexiert werden soll, die erforderliche Anmeldung entfernen.

Soft 404

Dieser Fehler beim Crawlen tritt üblicherweise auf, wenn eine Seite nicht vorhanden ist und der Server dennoch den Statuscode 200 (Seite erreichbar) zurückgibt. Google betrachtet eine Seite als Soft 404-Fehler, auch wenn es sich um eine Weiterleitung handelt, die inhaltlich nicht mit der ursprünglichen Seite übereinstimmt.

Lösung: Die betroffenen URLs sollten überprüft und ggf. auf einen anderen Statuscode geändert werden. Wenn der 301 Fehlercode ausgegeben wird, sollte eine Umleitung auf eine besser geeignete Seite erfolgen. Wenn die URL nicht mehr verfügbar ist, sollte ein 404 (= nicht gefunden) oder 410 Code (= entfernt) im Header der Website ausgegeben werden.

URL wegen eines anderen 4xx-Problems blockiert

Der Server reagiert mit einer Fehlermeldung im 4xx-Bereich, die keines der zuvor aufgetretenen Probleme genau beschreibt.

Lösung: Seite individuell mit der URL-Prüfung analysieren. Die Lösung ist vom Ergebnis abhängig.

Seite mit Weiterleitung

Google hat diese URL analysiert und erkannt, dass sie zu einer anderen Seite weiterleitet. Daher hat Google entschieden, die Seite nicht in den Suchergebnissen aufzuführen.

Lösung: Wenn die 301-Weiterleitung richtig eingesetzt ist besteht kein Handlungsbedarf. Falls nicht richtig, sollte die Weiterleitung gelöscht oder korrigiert werden.

Serverfehler (5xx)

Der Fehlercode 5xx tritt auf, wenn die angeforderte Ressource aufgrund eines Server-Fehlers nicht zurückgeliefert werden kann. Dies kann daran liegen:

Dieser Fehler sollte gar nicht vorkommen. Jeder Server sollte immer online sein und einwandfrei funktionieren.

Lösung: Oft sind es temporäre Probleme. Sollte die Website häufiger nicht erreichbar sein: den Server überprüfen und Serverfehler beheben.

Durch robots.txt-Datei blockiert

Hierbei handelt es sich um eine URL, die durch die robots.txt für Google blockiert wurde.

Lösung: Wenn das Zugriffsverbot nicht gewünscht ist, dem Crawler uneingeschränkten Zugriff erlauben und nicht angemeldete Benutzer zulassen. Wenn das Zugriffsverbot gewünscht ist empfehlen wir die Seite durch robots.txt oder „noindex“ Tag zu blockieren.

Weiterleitungsfehler

Die häufigsten Ursachen für einen Weiterleitungsfehler sind:

Lösung: Weiterleitung überprüfen und entsprechend ändern.

Es ist wichtig, die Meldungen in der Search Console regelmäßig zu checken und ggf. Verbesserungen an der Webseite vorzunehmen, damit Google die Webseite problemlos crawlen kann. Du wirst es merken: Je umfangreicher deine Website wird, desto wahrscheinlicher wird es sein, dass du nicht indexierte URLs in deinem Abdeckungsbericht hast – das ist vollkommen in Ordnung. Das Hauptziel besteht nicht darin, eine 100 % Indexierung der Website zu erreichen.

Ziel: Wichtige URLs crawlen und indexieren lassen und das Crawlbudget effizient nutzen.

Falls Du noch mehr Informationen zur Crawlbarkeit und Indexierung benötigst, findest du in dem Bericht zur Seitenindexierung der Google Search Console eine detaillierte Erklärung zu den Crawlingfehlern, der Indexabdeckung und weiteren mögliche Sicherheitsproblemen deiner Website.

Willst du mehr über Onpage-Optimierung lernen?

Fazit:

Um sicherzustellen, dass deine Website in den Suchergebnissen auffindbar ist, musst du die Grundlagen der technischen SEO verstehen. Eine wichtige Rolle spielen hierbei die Crawlbarkeit und die Indexierbarkeit durch Suchmaschinen wie Google & Co.

Wenn eine Seite gecrawlt wird, bedeutet dies, dass ein sogenannter Crawler sie besucht hat und alle Informationen auf dieser Seite gesammelt hat. Durch die Indexierung werden diese Informationen dann für eine spätere Suche abgespeichert. Es ist also von großer Bedeutung, dass deine Webseite korrekt gecrawlt und indexiert wird, damit sie auch in den SERPPs erscheint. Dabei solltest du darauf achten, dass die Inhalte deiner Website für Suchmaschinen leicht zugänglich sind und keine Fehler bei der Verlinkung oder dem Aufbau deiner URLs auftreten. Auch das Erstellen einer sitemap.xml-Datei oder robots.txt-Datei kann helfen, das Crawling-Verhalten zu optimieren und das Crawling-Budget effizient zu nutzen.

Überwache regelmäßig den Bericht zur Indexierungsabdeckung in der GSC und analysiere das Crawling und die Indexierung deiner Website, um Fehler schnell beheben zu können.

Du fragst dich, wie gut deine Seite für Google und Co. optimiert ist? Als Internetagentur verhelfen wir deiner Website zu mehr Sichtbarkeit. Vereinbare jetzt einen Beratungstermin und wir analysieren deine Seite auf Optimierungspotenziale.